| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | |||

| 5 | 6 | 7 | 8 | 9 | 10 | 11 |

| 12 | 13 | 14 | 15 | 16 | 17 | 18 |

| 19 | 20 | 21 | 22 | 23 | 24 | 25 |

| 26 | 27 | 28 | 29 | 30 | 31 |

- computervision

- 자료구조

- 딥러닝

- Meta Learning

- pytorch

- ML

- REACT

- CV

- SSL

- web

- GAN

- nlp

- Front

- 머신러닝

- PRML

- Python

- 3d

- dl

- Vision

- FineGrained

- Torch

- nerf

- cs

- algorithm

- 알고리즘

- classification

- math

- clean code

- Depth estimation

- FGVC

- Today

- Total

KalelPark's LAB

[논문 리뷰] Progressively Compressed Auto-Encoder for Self-supervised Representation Learning 본문

[논문 리뷰] Progressively Compressed Auto-Encoder for Self-supervised Representation Learning

kalelpark 2023. 3. 31. 10:10

Abstract

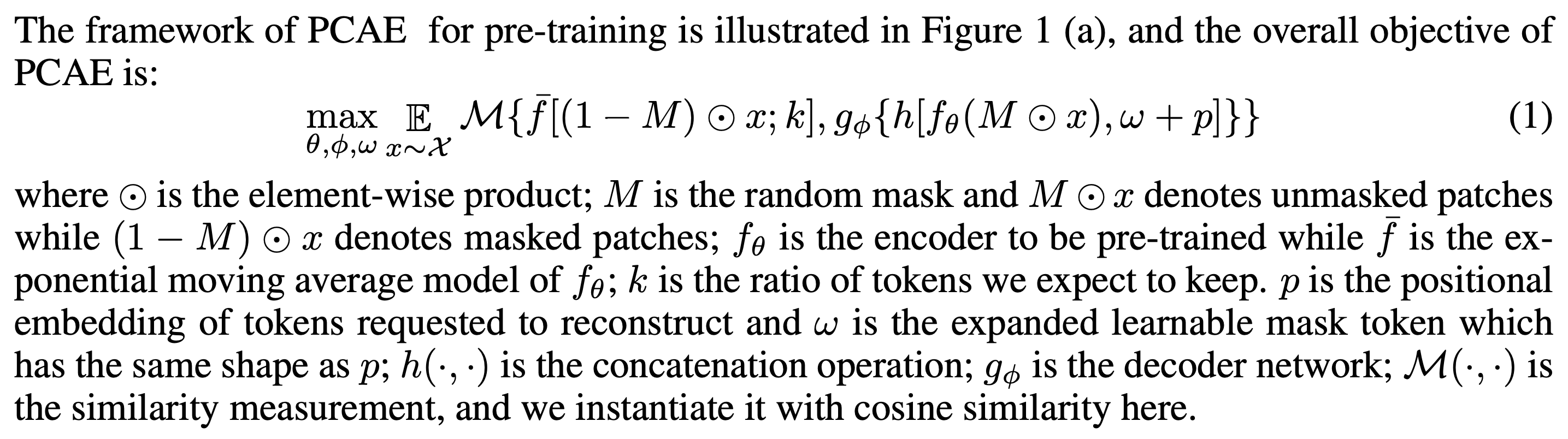

Masked Imaging에 관련해서 설명. 동일한 이미지 내, 상당히 매우 많은 부분을 Patch로 생성하는데, 이러한 방법은 상당히 많은 부분이 매우 높은 상관관계를 나타내며, 마스킹 된 부분이 상당히 많이 중복됩니다. 우리는 이러한 중복성이 기존 MIM 기반의 방법들을 무시하고, SSL에서 무시할 수 없는 오버헤드를 야기합니다. 본 논문에서는 compacting token과 단지 필요한 정보만을 남기기 위한 방법인

Progressively Compressed AutoEncoder를 설명합니다. 본 논문에서, 우리는 토큰 시퀀스의 평균을 가진 각 토큰 간의 간단하지만 효과적인 유사성 메트릭을 통하여, 이미지에서 중복 토큰을 식별하고자 합니다.

Introduction

본 논문에서는 Reconstructure target 내 중복된 부분을 감소시키기 위한 Progressively Compressed Auto-Encoder(PCAE)

이러한 방법의 핵심 아이디어는 모든 마스크를 복구하는 대신, 중복된 패치를 파악하고, 대표적인 대상만을 재구성합니다. 그러므로, Vision Transformer의 Self Attention을 활용하여, 폐기할 patch를 보존된 패치로 정보를 확산하여, 정보가 손실되는 것을 보완하고자 합니다. 구체적으로 Pre-training시에는 momentum encoder를 사용하고, 원래 재구성 대상이 아닌 encoder에 의해 생성된 토큰은 제거합니다. 또한, 정보 손실을 막기 위해, 우리는 점진적으로 정보를 버리는 방법을 선택합니다. 남은 문제는 토큰을 선택하는 것입니다.

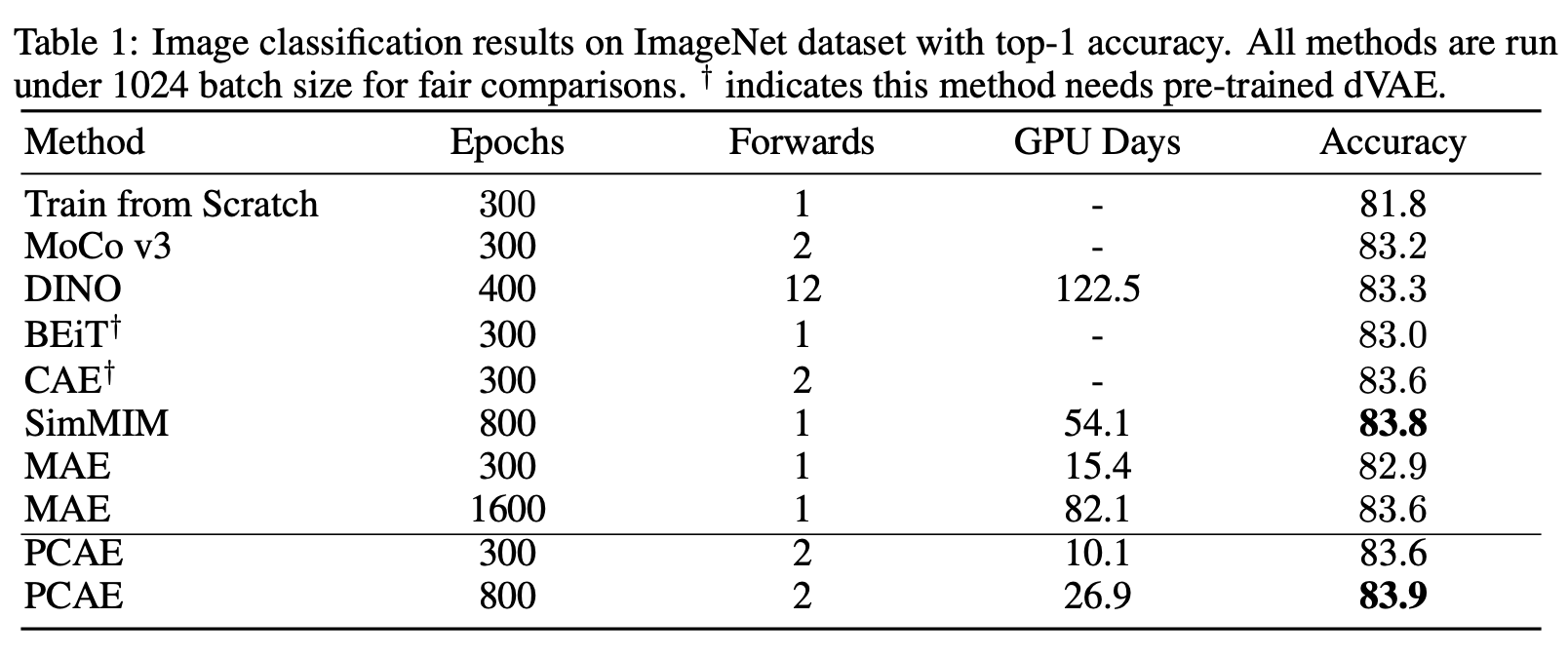

이러한 방법을 활용하면, 상당한 속도 개선을 하는 것이 가능합니다.

본 논문의 주된 기여로는,

1. MIM의 방법론을 분석하고, MIM의 중복성을 지적합니다.

2. 우리는 성능을 저하시키지 않고, 빠른 속도로 학습 가능한 Self-supervised learning approach를 제안합니다.

Related Work

Self-supervised learning

Self-supervised learning의 taxonomy를 지적하고, 어떠한 양상들이 있는지 설명하고 있다. 주로 Contrastive Learning과 Generative Learning에 대해서 언급을 하고 있다. 이후 MIM관련해서 설명을 진행하고 있음.

Dynamic vision transformer

최근 몇몇 불필요한 토큰은 제거하는 visiontransformer method가 연구되었습니다. 하지만 기존의 방법들은 Supervised Learning에서만 가능하였습니다. SSL에서는 없었음.

Method

Overview

PCAE framework는 읽어보기 바람.

해석하자면, 비대칭모델을 사용합니다. masking된 부분을 사용하는 모델과 masking되지 않은 부분을 사용하는 모델을 사용하는데 mask를 사용하지 않는 모델을 사용하는 모델에 EMA를 한 후, Patch를 가져와 유사도가 높은 것은 제거하는 식으로 각 stage를 밟습니다.

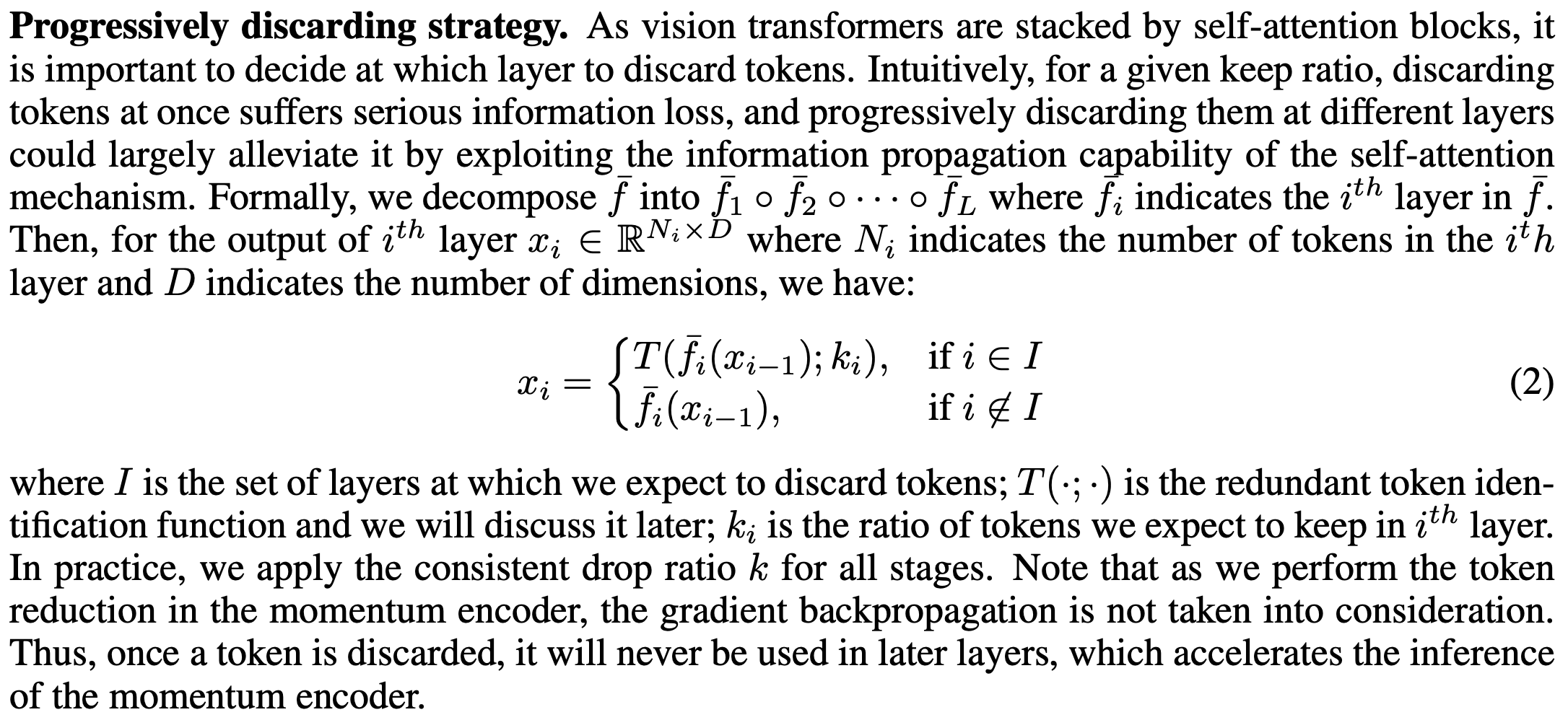

Progressive Token Reduction

Self-Attention block에 의해 쌓인 Vision Transforers는 어떤 layer로부터 token을 버릴지 정하는 것이 중요합니다. 결과적으로, 토큰을 한번에 버리는 것은 극심한 정보 손실을 야기할 수 있고, 다른 계층에서 점진적으로 페기한다면, Self-Attention은 정보 전파 기능을 활용하여, 정보 손실을 크게 완화할 수 있습니다.

Experiments

Conclusion

본 논문에서는, MIM에서의 중복되게 Masking되는 것을 다루기 위한 방법이 제시됩니다. 또한 상당한 성능 향상을 가져옵니다.

Reference