| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | |||

| 5 | 6 | 7 | 8 | 9 | 10 | 11 |

| 12 | 13 | 14 | 15 | 16 | 17 | 18 |

| 19 | 20 | 21 | 22 | 23 | 24 | 25 |

| 26 | 27 | 28 | 29 | 30 | 31 |

- GAN

- computervision

- cs

- dl

- nerf

- 알고리즘

- REACT

- ML

- Vision

- nlp

- Torch

- Python

- math

- algorithm

- Depth estimation

- 자료구조

- classification

- FGVC

- Meta Learning

- 딥러닝

- clean code

- PRML

- CV

- SSL

- Front

- pytorch

- 3d

- FineGrained

- web

- 머신러닝

- Today

- Total

KalelPark's LAB

[논문 리뷰] Counterfactual Attention Learning [2021] 본문

[논문 리뷰] Counterfactual Attention Learning [2021]

kalelpark 2022. 12. 5. 12:41

GitHub를 참고하시면, CODE 및 다양한 논문 리뷰가 있습니다! 하단 링크를 참고하시기 바랍니다.

(+ Star 및 Follow는 사랑입니다..!)

https://github.com/kalelpark/AI_PAPER

GitHub - kalelpark/AI_PAPER: Machine Learning & Deep Learning AI PAPER

Machine Learning & Deep Learning AI PAPER. Contribute to kalelpark/AI_PAPER development by creating an account on GitHub.

github.com

Abstract

본 논문에서는, causal inference기반의 effective attention을 효율적으로, 학습하기 위해서, counterfactual attention learning 방법을 제안합니다.

attention quality를 측정하는 tool과 학습과정을 안내하는 powerful supervisory signal를 제공하는 counterfactual causality를 통하여, attention을 학습할 것을 제안합니다.

Introduction

fine-grained visual recognition에서는, visual attention mechanism이 여러가지 연구되었습니다. 그럼에도 불구하고, effective attention은 여전히 해결되지 않은 난제입니다.

연구를 진행하기에 앞서, CUB dataset을 분석을 해봤을 때, classification 시, attributres and environment에 관하여, 편향이 있을 수 있다는 것을 파악하였으며, classification에서 배경과 단일 분류는 신뢰할 수 있지 않는 단서가 됨을 시사합니다.

attentions quantitatively의 quality를 평가할 수 있는 효율적인 tool이 없기 때문에, 잘못된 attention을 찾는 것은 상당히 어렵습니다.

본 논문에서는 Counterfactual attention learning(CAL) causal inference에 기반하여,

attention을 학습하는 방법을 제안합니다.

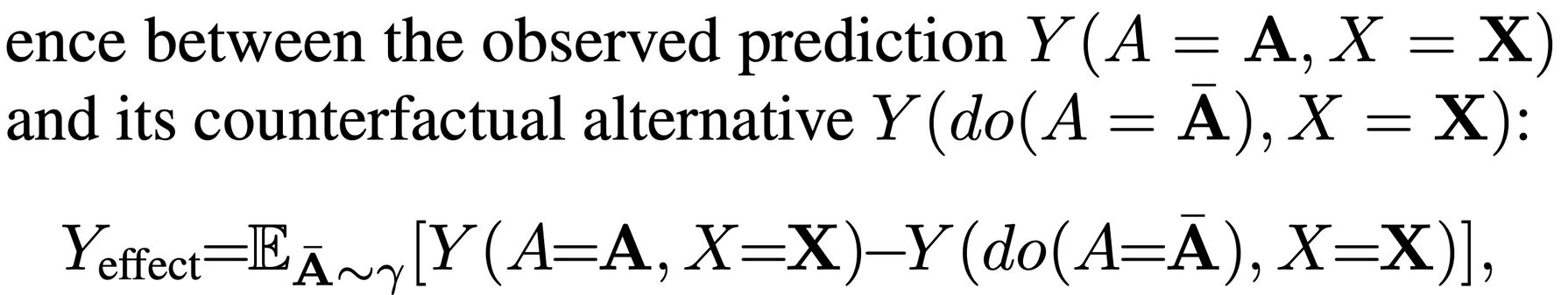

기반이 되는 Idea로는, final prediction에서, counterfactuals과 fact의 effect를 비교함으로써, attentions의 quality를 정량화 하는 것입니다.

Related Work

Causal Reasoning in Vision

Deep Learning과 Causal reasoning의 idea를 결합하는 것은 계속해서 발전해왔습니다. Causal inference는 Model이 data를 학습할 때, bias을 방지하며, 효율적인 학습에 초점을 갖게합니다. 논문에서는, visual attention module의 context를 causality로 연구합니다. 이것은 이전에 사용하지 않은 새로운 방안입니다.

Approach

Attention Models for Fine-Grained Recognition

본 논문에서는, attention maps과 관련하여 연구를 진행합니다. 특히 우리의 모델은 multi-head attention module을 활용합니다. 그리고, attention module은 object의 spatial distribution을 학습합니다.

이러한 방식은 attention map으로 표현하는 것이 가능합니다.

Attention Models in Causal Graph

Counterfactual method를 활용하기 이전에, 첫째로, 우리는 language of causal graph내의 모델 위에서, 어떻게 reformulate하는지 설명합니다.

Causal Model내에서의 node는 CNN의 feature map을 포함하여 attention model내의 variables를 표현합니다.

Image와 attention Map 사이에서의 관계를 통하여, final prediction을 추출하는데 이때, Attention Map을 기준으로 Image는 attention Map의 parent node이고, final prediction은 child node가 됩니다.

Causal Graph를 모델에 적용함으로써, 더 넒은 범위의 attention learning problems으로 연장할 수 있습니다.

Counterfactual Attention Learning

Causal inference는 변수사이에서 causality를 분석함으로써, black box를 제외하는데 도움을 줍니다. attention의 quality를 측정하기 위해, causalities를 사용합니다. 그리고, attention map을 생성하는데 도움을 주는 network를 encourage함으로서, model을 개선합니다.

Causal Inference methods에서 영감을 받아, counterfactual intervention을 활용하여, Visual Attention을 시행합니다.

attention 기법은, final prediction과 비교하여, wrong attention의 부분을 개선하는 것이 가능하며, 학습하는 것이 가능합니다.

새로운 Optimizer는 2가지를 나타냅니다.

- attention model은 부정확하게 attention을 한 부분에 대한 예측을 개선합니다.

- wrong attention에 penalize를 함으로써, main clue에 더욱 초점을 두도록 합니다.

Experiments

Conclusion

본 논문에서는 causal inference에 기반한, 효율적인 attention 기법인 counterfactual attention을 소개합니다. final prediction을 위한 counterfactuals과 facts를 비교함으로써, framework를 고안합니다.

CAL(Counterfactual Attention Learning)기법은 모델의 특징에 구애받지 않고 적용 가능하며, dataset의 편향을 방지할 수 있습니다.

Reference

Counterfactual Attention Learning for Fine-Grained Visual Categorization and Re-identification

Counterfactual Attention Learning for Fine-Grained Visual Categorization and Re-identification

Attention mechanism has demonstrated great potential in fine-grained visual recognition tasks. In this paper, we present a counterfactual attention learning method to learn more effective attention based on causal inference. Unlike most existing methods th

arxiv.org

GitHub를 참고하시면, CODE 및 다양한 논문 리뷰가 있습니다! 하단 링크를 참고하시기 바랍니다.

(+ Star 및 Follow는 사랑입니다..!)

https://github.com/kalelpark/AI_PAPER

GitHub - kalelpark/AI_PAPER: Machine Learning & Deep Learning AI PAPER

Machine Learning & Deep Learning AI PAPER. Contribute to kalelpark/AI_PAPER development by creating an account on GitHub.

github.com

'Data Science > Fine Grained' 카테고리의 다른 글

| [논문 리뷰] TransFG [2021] (0) | 2022.12.10 |

|---|---|

| [논문 리뷰] PIM(Plug in Module) [ 2022 ] (0) | 2022.12.06 |

| [논문 리뷰] Look into Object [2020] (0) | 2022.12.03 |

| [논문 리뷰] Progressive Multi Granularity [2020] (0) | 2022.11.30 |

| [논문 리뷰] Mixture Granularity Specific Expert [2019] (0) | 2022.11.29 |