| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 | 31 |

- algorithm

- FineGrained

- computervision

- dl

- cs

- 자료구조

- classification

- 딥러닝

- math

- PRML

- Meta Learning

- GAN

- Vision

- ML

- FGVC

- web

- Torch

- SSL

- clean code

- CV

- Python

- 3d

- pytorch

- Depth estimation

- 알고리즘

- nlp

- nerf

- 머신러닝

- REACT

- Front

- Today

- Total

KalelPark's LAB

[ 논문 리뷰 ] Deep Clustering for Unsupervised Learning of Visual Features 본문

[ 논문 리뷰 ] Deep Clustering for Unsupervised Learning of Visual Features

kalelpark 2023. 2. 8. 16:52

GitHub를 참고하시면, CODE 및 다양한 논문 리뷰가 있습니다! 하단 링크를 참고하시기 바랍니다.

(+ Star 및 Follow는 사랑입니다..!)

GitHub - kalelpark/Awesome-ComputerVision: Awesome-ComputerVision

Awesome-ComputerVision. Contribute to kalelpark/Awesome-ComputerVision development by creating an account on GitHub.

github.com

Abstract

ComputerVision에서는 Clustering이 계속되어 연구되고 있다. 본 논문에서는 Neural Network의 Parameter와 feature를 동시에 clustering하는 방법을 학습한다. DeepCluster는 K-means와 같이 계속해서 학습하고, Network의 weight를 업데이트하기 위해 assignment를 학습한다.

Introduction

이전의 연구에서의 모델에서는 차원 감소, 밀도 감소를 기반으로 하여 Unsupervised Method가 계속해서 연구가 되고 있다. ComputerVision에서 적용하기에는 문제점이 있다. 주된 문제점으로는 Clustering method는 고정된 feature에서 활용되어야 한다는 점과 feature를 동시에 학습하기에는 상당한 어려움이 있다.

본 논문에서는 ConvNet을 학습시키기위한 end-to-end 방법론과 새로운 Clustering방법을 제시합니다.

본 논문에서는 K-means에 초점을 맞춰 학습을 진행하지만, 또 다른 접근법으로는 Power Iteration Clustering방법을 제시합니다.

전반적인 학습방법은 일반적인 방법을 다시 활용함으로써, 일반적인 Convnet의 흐름과 가깝다.

Self Supervised의 방법론과 다르게 Clustering의 장점은 domatin knowledge가 거의 없어도 되며, Input으로부터 구체적인 signal이 없어도 된다는 장점이 있습니다. 본 논문에서는 단서가 없는 데이터 분포를 학습할 때, SOTA를 달성함을 설명합니다.

Contribute

1. 약간의 step과 k-means와 같은 일반적인 알고리즘을 활용함으로써, 새로운 Unsupervised Method를 제안합니다.

2. 일반적인 transfer를 unsupervised learning에서 활용가능하다는 점이 있습니다.

3. Uncured image Distribution에서 학습 시, SOTA의 성능을 보여줍니다.

Related Work

Unsupervised Learning of features, Self-Supervised Learning, Generative models

Method

Preliminaires

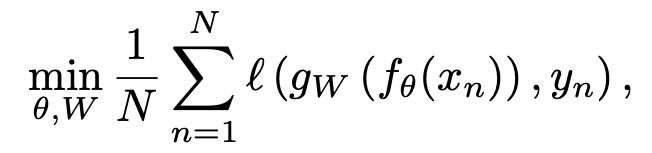

ComputerVision에서는 좋은 featruization 하는 것을 요구하고 있습니다. 이러한 맥락에서 고정된 차원으로 image를 매핑하기 위해 ConvNet을 활용하는 것은 좋은 선택이다. (하단 표기법 사용)

하단의 수식을 보자면, f 함수를 활용하여 x 이미지를 mapping한 후, g를 활용하여 classifier를 한후 logistic loss를 최소화하는 것이다.

이때 최소화를 함으로써, f함수의 parameter w와 g 함수의 parameter 세타를 동시에 최적화시킵니다.

Unsupervised Learning by Clustering

Gaussian Distribution으로부터 샘플링하는 경우, f로부터 좋은 feature를 생성하지 못한다. 하지만. 일반적인 tasnfer task에서 좋은 성능을 나타낸다. ImageNet 1K에서 12%의 성능을 나타낸다. Convnet의 차별적인 부분을 bootstrap하기 위해 약한 신호를 추출하는 방법을 연구한다. 우리는 convnet의 output을 cluster하고 pseudo-label로 활용하여 학습합니다.

Avoiding trivial solution

Empty Clusters

Discriminative model(Clustering 모델)은 class간의 결정 경계를 학습하는데, 최적의 결정 경계 설정하는 것은 모든 입력을 하나의 cluster라고 할당하는 것이다. Clustering동안 할당되지 않은 cluster를 무작위 cluster와 동일하게 놓고 다시 학습하여 해결하는 것이 가능합니다.

Trivial Parametrization

데이터 불균형에서도 발생하는 문제로 major class에 중점적으로 parameter가 학습됩니다. 클래스의 균형이 무너지는 경우 각 cluster에 할당된 데이터 수의 역수를 loss에 곱해주면 해결하는 것이 가능합니다.

Implementation details

Experiments

Conclusion

본 논문에서는 ConvNet에 Unsupervised를 적용한 Clastering 방법론을 제안합니다. Convnet에 의하여 생긴 feature를 반복적으로 k-means하고, pseudo-label로써 배정한 feature를 discirminative loss로 활용합니다.

Reference

https://arxiv.org/abs/1807.05520

Deep Clustering for Unsupervised Learning of Visual Features

Clustering is a class of unsupervised learning methods that has been extensively applied and studied in computer vision. Little work has been done to adapt it to the end-to-end training of visual features on large scale datasets. In this work, we present D

arxiv.org

https://arxiv.org/abs/1511.06335

Unsupervised Deep Embedding for Clustering Analysis

Clustering is central to many data-driven application domains and has been studied extensively in terms of distance functions and grouping algorithms. Relatively little work has focused on learning representations for clustering. In this paper, we propose

arxiv.org

https://ieeexplore.ieee.org/document/8237888

Deep Adaptive Image Clustering

Image clustering is a crucial but challenging task in machine learning and computer vision. Existing methods often ignore the combination between feature learning and clustering. To tackle this problem, we propose Deep Adaptive Clustering (DAC) that recast

ieeexplore.ieee.org