| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | |||

| 5 | 6 | 7 | 8 | 9 | 10 | 11 |

| 12 | 13 | 14 | 15 | 16 | 17 | 18 |

| 19 | 20 | 21 | 22 | 23 | 24 | 25 |

| 26 | 27 | 28 | 29 | 30 | 31 |

- classification

- 3d

- dl

- 딥러닝

- CV

- 머신러닝

- cs

- REACT

- nerf

- clean code

- math

- FineGrained

- SSL

- Torch

- PRML

- Front

- Python

- pytorch

- FGVC

- 자료구조

- GAN

- computervision

- ML

- Meta Learning

- 알고리즘

- nlp

- algorithm

- Depth estimation

- Vision

- web

- Today

- Total

KalelPark's LAB

[ 논문 리뷰 ] One-shot Learning with Memory-Augmented Neural Networks? 본문

[ 논문 리뷰 ] One-shot Learning with Memory-Augmented Neural Networks?

kalelpark 2022. 12. 29. 14:19

GitHub를 참고하시면, CODE 및 다양한 논문 리뷰가 있습니다! 하단 링크를 참고하시기 바랍니다.

(+ Star 및 Follow는 사랑입니다..!)

https://github.com/kalelpark/Awesome-ComputerVision

GitHub - kalelpark/Awesome-ComputerVision: Awesome-ComputerVision

Awesome-ComputerVision. Contribute to kalelpark/Awesome-ComputerVision development by creating an account on GitHub.

github.com

Abstract

Deep Neural Network에서는 여전히 영구적인 문제가 존재합니다. 새로운 데이터를 직면할 때, 모델은 새로운 정보에 대한 적절한 파라미터를 학습해야하는 inefficiently가 존재합니다.

NTM(Neural Turing Machines)과 같은 Architecture는 quickly encode를 제공하고 new information을 빠르게 반영합니다.

그러한 이유로, 기존 모델의 단점을 잠재적으로 제거합니다.

본 논문에서는 새로운 데이터를 빠르게 학습하기 위한 memory-augmented neural network의 능력을 증명합니다. 뿐만 아니라,

소규모 데이터를 가지고, 정확한 예측을 데이터에 적용하는 것이 가능합니다.

focusing mechanism 기반 하에 memory location을 추가적으로 사용하는 이전의 방법론과는 다르게, memory content에 초점을 맞춘 외부 메모리에 접근하는 새로운 방법을 소개합니다.

Introduction

일반적으로 Deep Learning은 gradient-based optimization에 초점을 두고 학습을 진행되었습니다. 하지만, 최근에 많은 관심들은 적은 양의 데이터로부터 신속한 추론이 필요합니다.

Single Observiations에서 One-shot learning은 급격한 변화를 하는 것에 제한이 있습니다. 일반적으로, gradient-based solution은 data를 다시 학습해야 합니다. 이러한 전략은 학습하는데 상당히 어려움이 존재하며, 추론에서 상당한 재앙을 이끌어 냅니다.

이러한 어려움속에서, non-parametric methods는 종종 좋은 방법으로 여겨질 수 있습니다.

Meta-learning은 일반적으로 두 단계에 거쳐 학습을 하는 scenario로 불립니다. 이러한 학습방법은 작업 전반에 거쳐 점진적인 지식을 얻음으로써, 학습이 guide됩니다. 이러한 방식은 target domains를 넘우 task structure 다양성을 학습합니다.

그리하여, 일반적으로 Meta-learing은 learning to learn이라고 불립니다. 즉, 학습하는 방법을 학습하는 것.

memory capacities를 가진 Neural Network는 meta-learning의 가능성을 증명하였습니다. 이러한 방식은 weight update를 통하여, bias를 shift하고, 메모리 저장소에서 표현을 신속하게 cache하는 방법을 학습함으로써, Output을 조절합니다.

예를들어, meta-learn에 의해 학습된 LSTM은 이전에 보지 못한 소량의 data를 가진 dataset에 대해서

빠르게 학습하는 것이 가능합니다.

하지만 구조화되지 않은 순환신경망에 내재된 memory를 사용하는 specific strategy는 각각의 새로운 작업이 신속하게 인코딩되기 위해 상당한 양의 새로운 정보를 필요로 하는 설정할 가능성은 낮다.

이러한 솔루션을 확장하기 위해서는, 몇 가지 조건이 필요합니다.

1. information은 다룰수 있고, 안정적인 상태인 표현력을 가진 상태로 메모리내에 저장되어야 합니다.

2. number of parameters는 메모리의 크기에 정확히 맞출 필요가 없어야 합니다.

이러한 조건들은 LSTM에서 발생하지 않습니다.

하지만, 최근의 Neural Turing Machines와 Memory Network에서는 반드시 필요한 선수조건으로 여겨집니다.

그리하여, 본 논문에서는 meta-learning의 문제점을 연구하고,

memory-augmented neural network(MANN)의 관점으로 재설정합니다.

memory-augmented neural network(MANN)는 2가지 단어로 말할 수 있습니다.

1. raw data의 유용한 representation을 얻기위한 추상적인 방법을 천천히 학습하는 능력

2. single presentation이후에 이전에 관찰하지 못한 정보를 빠르게 연결하는 능력

이러한 방식은 meta-learning에서 강건함을 보여줄 뿐만아니라, 딥러닝의 광범위한 문제에 효율적으로 적용될 수 있음을 보여줍니다.

Meta-Learning Task Methodology

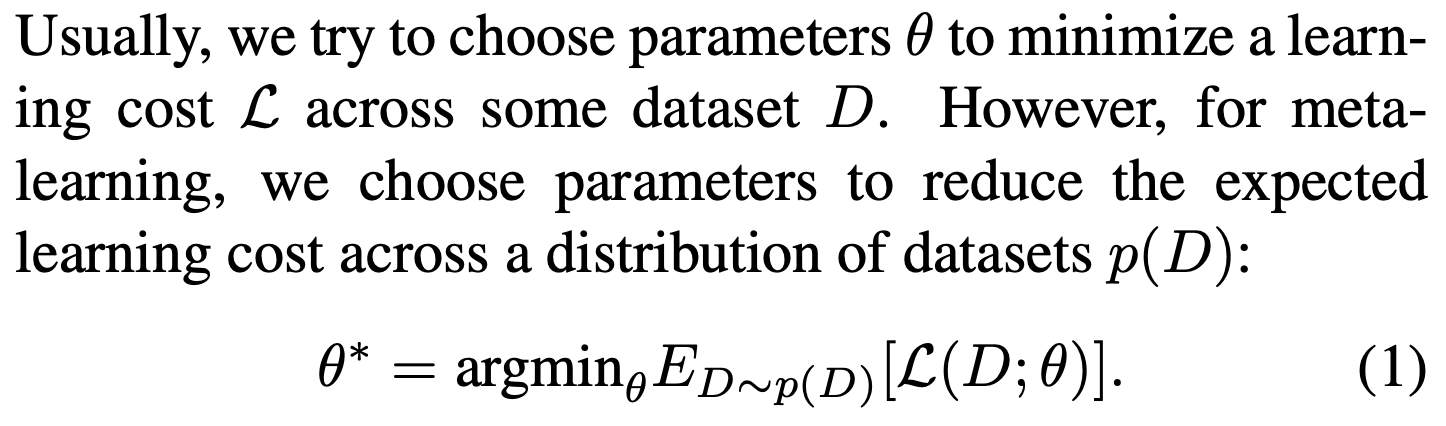

일반적인 learning과 다르게, Meta-learning은 learning cost를 감소시키기 위한 paramter를 찾으려고 한다.

중요한 것은 labels는 dataset에서 dataset으로부터, shuffle됩니다.

이러한 방식은 Network가 weights에서 sample-class binding을 천천히 학습하는 것으로부터 방지합니다.

대신에, 적절한 label이 제시될 때까지, data samples을 memory내에 가지고 있는 것을 학습할 필요가 있습니다.

이후, sample-class information이 bound되고, 나중에 사용될 수 있도록 저장됩니다.

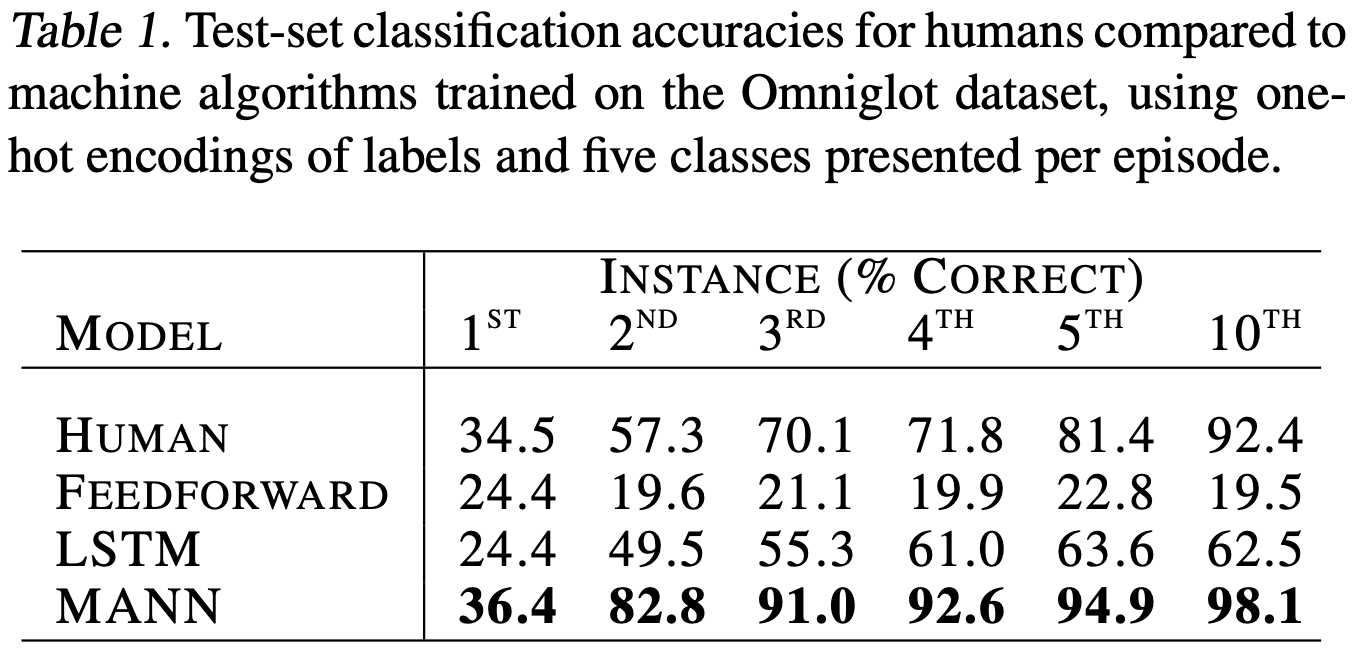

ideal performance는 first presentation of class에 대한 random guess를 포함하고 있는 것입니다, 그리고, 성공적인 accuracy를 위해 메모리를 활용하는 것입니다.

Memory-Augmented Model

Neural Truing Machines

* 참고하시기 바랍니다.

https://kalelpark.tistory.com/31

[Meta Learning] Neural Turing Machines이란?

NTM(Neural Turing Machines) * Meta Learning의 MANN(Memory-Augmented Neural Networks)와 SNAIL(Neural Attentive Meta-Learner) 두 알고리즘에 대해서 이해하기 위해 공부해야 하는 선수조건입니다. - 이름 그대로, Neural Networks

kalelpark.tistory.com

Least Recently Used Access

이전의 NTM에서는 메모리는 content와 lcation에 의하여, 다뤄줬습니다. Location-based addressing은 iterative steps에 의하여 촉진되었습니다. 그리고, tape와 같이 유사하게 진행이 되었으며, 오랜 기간동안 memory를 가지고 있습니다. 이러한 방법들은, Sequence기반의 task에서 상당한 advantages가 있습니다.

하지만, 이러한 유형의 접근은 순서와 관계없는 정보의 결합을 강조하는 task에서 최적의 방법은 아닙니다.

우리의 모델에 memory를 쓰기는 Least Recently Used Access라고 불리는 module에 포함을 하고 있습니다.

LRUA는 단지, 가장 적게 활용되는 memory location 또는 최근에 사용된 memory location에 메모리를 작성하는 content-baed memory 기록지입니다.

Experiments

'Data Science > Meta Learning' 카테고리의 다른 글

| [ Meta Learning ] Meta-Learning based on Metric (2) | 2023.01.15 |

|---|---|

| [ 논문 리뷰 ] Siamese Neural Networks for One-shot Image Recognition (1) | 2023.01.08 |

| [Meta Learning] Neural Turing Machines이란? (2) | 2022.12.28 |

| [ Meta Learning ] 모델 기반 메타 러닝 이해하기 (0) | 2022.12.28 |

| [Meta Learning] MetaDataLoader 구현 (0) | 2022.12.28 |