| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |

- PRML

- Front

- cs

- SSL

- math

- 자료구조

- REACT

- 머신러닝

- nerf

- web

- Vision

- 딥러닝

- ML

- 알고리즘

- nlp

- dl

- classification

- Python

- computervision

- Meta Learning

- pytorch

- FineGrained

- algorithm

- Depth estimation

- clean code

- GAN

- Torch

- FGVC

- 3d

- CV

- Today

- Total

KalelPark's LAB

[논문 리뷰] BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding 본문

[논문 리뷰] BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding

kalelpark 2023. 3. 12. 18:37

Abstract

BERT(Bidirectional Encoder Representations Transformers)에 대해서 소개합니다.

BERT는 모든 layer로부터 양방향 정보를 활용하여, 학습합니다. 이후, downstream시, 단지 하나의 layer를 추가하여도, pretraining이 편리하게 되며, 여러 분야에서 SOTA를 달성합니다.

Introduction

기존 GPT(Generative Pre-trained Transformer)는 단방향이라 문장의 맥락을 해석하는데 상당히 제한이 있음을 언급합니다. 본 논문에서는, fine-tuning을 개선한 BERT(Bidirectional Encoder Representation)를 소개합니다.

본 논문에서 말하는 주된 기여 3가지는

1. BERT는 양방향의 표현을 학습하기 위해서, masked language models을 사용하는 것이 가능합니다.

2. BERT는 단지 layer 1개를 추가하여, pre-training이 가능하기에, 많은 Enginnering이 필요하지 않습니다.

Model Architecture

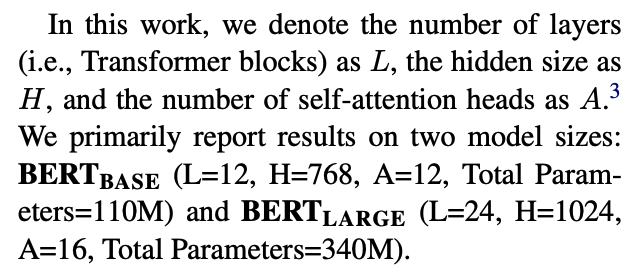

BERT는 attention기반 multi-layer bidirectional 구조이다.

Token Embedding시, Word piece 임베딩 방식을 사용합니다. Word Piece 임베딩은 가장 긴 길이의 sub-word를 하나의 단위로 만들어 사용합니다. 즉, 자주 등장하는 단어는 자체의 단위가 되고, 자주 등장하지 않는 단어는, sub-word가 되게끔 계속해서 쪼개어 생성합니다.

Conclusion

최근 Large Language Model의 이해를 하는 것이 대두가 되고 있다. 특히, Unsupervised Learning을 사용함으로써 모델의 성능을 극대화하고 있다. 본 논문의 주된 기여는, 기존의 방식과는 다른 bidirectional architecture 구조를 만들었다는 것이다.

Reference

BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding

We introduce a new language representation model called BERT, which stands for Bidirectional Encoder Representations from Transformers. Unlike recent language representation models, BERT is designed to pre-train deep bidirectional representations from unla

arxiv.org

'Data Science > Large Language Model' 카테고리의 다른 글

| [논문 리뷰] GPT : Improving Language Understandingby Generative Pre-Training (0) | 2023.03.20 |

|---|